Automation Bias als Rechtsproblem

Menschliche Entscheidungen folgen einer begrenzten Rationalität. In einer immer komplexer werdenden Welt alle relevanten Faktoren für Entscheidungsprozesse miteinzubeziehen, erscheint zunehmend schwieriger. Die Unterstützung menschlicher Entscheidungsprozesse durch algorithmenbasierte Systeme ist deshalb allgegenwärtig und unumkehrbar.

Im Fokus der (wissenschaftlichen) Diskussionen stehen aber vorrangig Visionen „Künstlicher Intelligenz“, der Robotik und vollautomatisierter Entscheidungsvorgänge. Die Risiken algorithmenbasierter Entscheidungsunterstützung sind rechtlich und institutionell nicht hinreichend reflektiert, aber tatsächlich weit verbreitet.

-

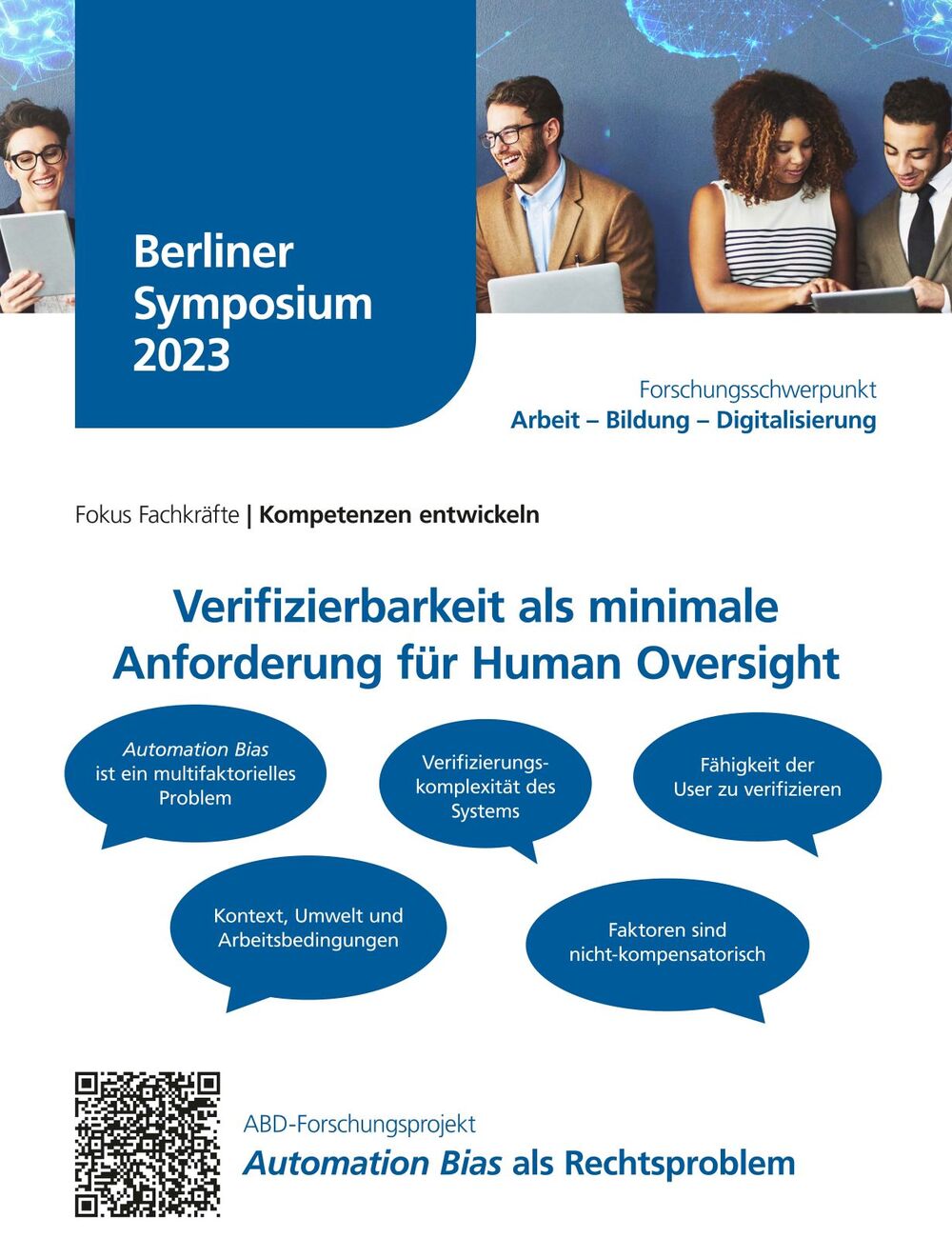

Der automation bias ist das verhaltenspsychologisch nachgewiesene Phänomen, dass Menschen wider besseren Wissen auf Vorschläge und Entscheidungen von Maschinen vertrauen. Durch einen flächendeckenden Einsatz solcher Systeme, z.B. im Bildungsbereich oder der Leistungsverwaltung entfalten solche biases eine Hebelwirkungen und potenzieren die Zahl der Betroffenen. Insbesondere in Umgebungen, in denen Menschen eine Vielzahl gleichgelagerter Entscheidungen routinemäßig treffen müssen, steigt die Gefahr des automation bias. Expert:innenwissen allein schützt davor nicht.

Für diese Risiken müssen Organisationen, Führungskräfte und Sachbearbeiter:innen sensibilisiert werden. Qualitäts- und Ergebnissicherung sowie Grundrechtsschutz durch Verfahren sind etablierte rechtliche Konzepte. Rechtlich reflektiert sind die Risiken algorithmenbasierter Entscheidungen bisher nur punktuell, die als „KI-Vorschrift“ gehandelte Norm des Art. 22 DSGVO erfasst entscheidungsunterstützende Systeme explizit nicht.

Das Projekt entwickelt aus rechtlicher Perspektive unter starker Einbeziehung interdisziplinärer Erkenntnisse, insbesondere aus Arbeitsethik und Psychologie Lösungsansätze, um dem automation bias zu begegnen.

-

Veröffentlichungen

Hondrich, Lukas; Ruschemeier, Hannah, (Alvarez, M.; Fabris, A.; Zehlike, M., Loi, M., Heitz, C., Hertweck, C.) (2023): Addressing Automation Bias through Verifiability, Conference Proceedings Winterthur EWAF 2023

Ruschemeier, Hannah: Automation Bias in the Public Sector – a Legal Perspective, in: Weizenbaum Conference Proceedings 2023, 59-69.

Under review: Automation Bias – an interdisciplinary perspective from law and psychology. Ruschemeier, Hannah; Hondrich, Lukas

Konferenzteilnahmen und Vorträge

Hondrich, Lukas: „Addressing Automation Bias through Verifiability, Eurpopean Workshop for Algorithmic Fairness, Winterthur, 07.06.2023

Hondrich, Lukas: Weizenbaum Conference #5: AI, Big Data, Social Media, and People on the Move, Berlin, 19. – 20.06.2023

Hondrich, Lukas: Responsible and Open Foundation Foundation Models, Princeton (remote), 21.09.2023

Hondrich, Lukas: Shifting AI Controversies, Berlin, 28.-29.01.2024

Ruschemeier, Hannah: Shifting AI Controversies, Berlin, 28.-29.01.2024

Ruschemeier, Hannah: Weizenbaum Jahreskonferenz, Berlin, Juni 2022

Projektbeteiligte

Foto: Michael Schwettmann

Foto: Michael Schwettmann

Jun.-Prof. Dr. Hannah Ruschemeier

Projektleitung

E-Mail: hannah.ruschemeier

Telefon: +49 2331 987-4872

Lehrgebiet Öffentliches Recht mit Schwerpunkt Recht der Digitalisierung/Datenschutzrecht, Rechtswissenschaftliche Fakultät