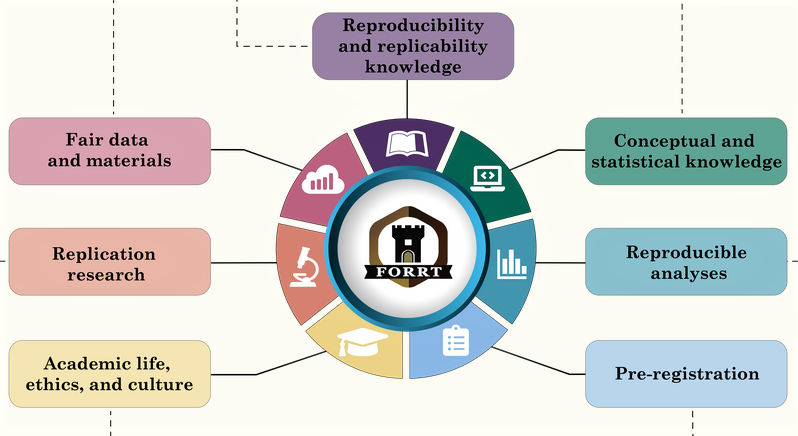

Open Science für Forschende

Reproducibility and Replicability Knowledge

-

Foto: Sabrina Kornberger, CC-BY-NC

Foto: Sabrina Kornberger, CC-BY-NC -

Foto: Sabrina Kornberger, CC-BY-NC

Foto: Sabrina Kornberger, CC-BY-NC -

Foto: Sabrina Kornberger, CC-BY-NC

Foto: Sabrina Kornberger, CC-BY-NC -

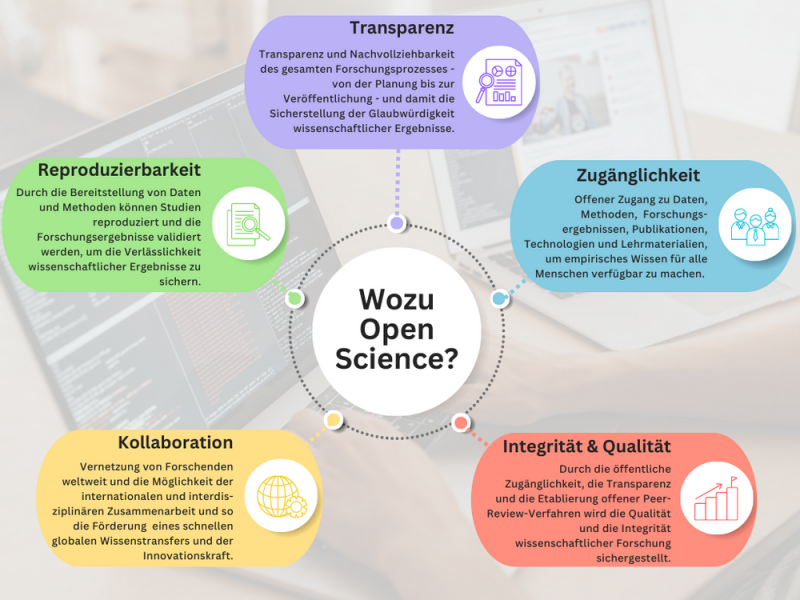

Open Science als Konzept einer offenen und transparenten Wissenschaft gilt als aussichtsreicher Ansatz zur Förderung der Transparenz, Reproduzierbarkeit und Zugänglichkeit wissenschaftlicher Forschung. Durch die Veröffentlichung von Daten, Methoden und Forschungsergebnissen soll die Zusammenarbeit zwischen Forschenden verbessert, der Wissensaustausch beschleunigt und die Replikation von Studien erleichtert werden, mit dem Ziel, die Qualität, Integrität, Glaubwürdigkeit und Validität der Forschung zu erhöhen.

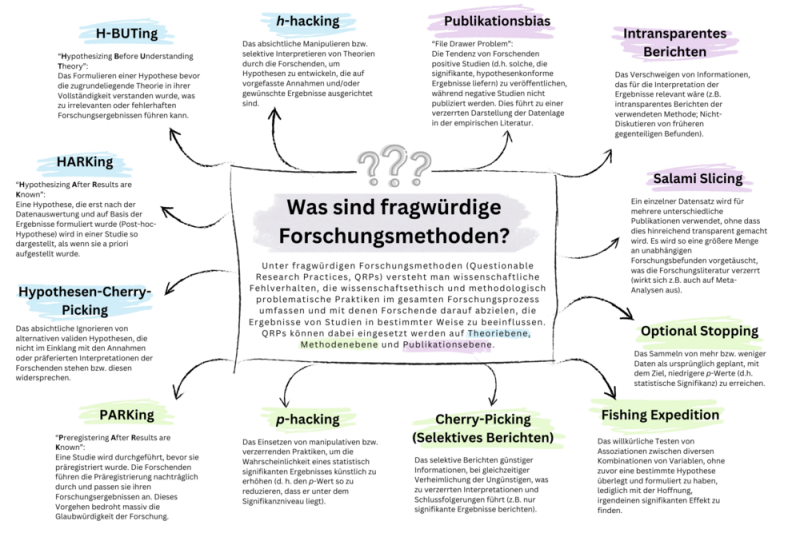

Doch es gibt auch kritische Stimmen: Ein genanntes Problem betrifft die finanziellen, infrastrukturellen und sozialen Barrieren, die den Zugang zu Open-Access-Publikationen erschweren. Beispielsweise hemmen Bezahlschranken die Open-Access-Veröffentlichung in Zeitschriften für kleinere Institutionen oder Forschende, die über weniger finanzielle Ressourcen verfügen. An anderer Stelle wird darauf hingewiesen, dass die Offenlegung von Daten datenschutzrechtliche Herausforderungen mit sich bringen kann. Auch wird die Frage diskutiert, ob die Reproduzierbarkeit als Aspekt von Open Science überbetont wird: Kritiker*innen melden Zweifel an der uneingeschränkten Nützlichkeit von Replikationsstudien an und argumentieren, dass die wiederholte Durchführung von Studien nicht zwangsläufig zur Validierung und neuen wissenschaftlichen Erkenntnissen führt, sondern eher zum Publikationsbias beitragen könnte. Weiter wird kritisch angemerkt, dass Offenheit allein nicht ausreichend ist, sondern es festgesetzter, ausführlicher Richtlinien und Standards für die wissenschaftliche Forschung bedarf. Andernfalls bergen auch durchaus sinnvolle Open Science Praktiken Risiken für sogenannte questionable research practices: So kann die Veröffentlichung von Studien-Registrierungen das Problem des sogenannten HARKings (Hypothesizing After Results Known) sogar verschleiern, nämlich dann, wenn die Registrierung von Studienplan und Hypothesen nicht konsequent vor der Datenerhebung erfolgt, sondern im schlimmsten Fall sogar erst nach der Durchführung der Studie (PARKing: Preregistering After Results are Known).

Aus diesen komplexen Debatten über Open Science gehen sowohl die vielversprechenden Vorteile, die eine offene und transparente Wissenschaft mit sich bringen, hervor, als auch die bestehenden Herausforderungen, denen man sich zukünftig weiterhin widmen muss.

Conceptual and Statistical Knowledge

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

Pre-Registration

Bei einer Präregistrierung beschreiben Forschende vor Beginn der Datenerhebung (mindestens aber vor der Inspektion bereits gewonnener oder noch in der Erhebung befindlicher Daten, z. B. im Falle von Sekundärdatenanalysen) die zentrale(n) Forschungsfrage(n) und Hypothesen, Details des Forschungsdesigns, der geplanten Stichprobe und der statistischen Analysen ihrer geplanten Studie und reichen diese bei einem Repositorium ein. Das erhöht die Transparenz im Forschungsprozess und schützt vor fragwürdigen Forschungspraktiken, wie z. B. dem sogenannten „HARKing“ (hypothesizing after results are known). Mit dem Einreichen bei einem Repositorium wird die Präregistrierung üblicherweise mit einem Zeitstempel versehen und kann nicht mehr geändert oder gelöscht werden.

Die nachfolgende Übersicht bietet eine Kurzinformation dreier häufig genutzter Optionen für die Präregistrierung.

-

- Link: https://aspredicted.org/

- AsPredicted erlaubt standardisierte Präregistrierungen von Studienplänen (inkl. Hypothesen, Fallzahl- und Analyseplanung) anhand von 10 vorgegebenen Fragen. Die durch diese Pflicht-Fragen vorgegebene Struktur erleichtert auch „Einsteigern“ das Anlegen einer Präregistrierung.

- Abgeschlossene (von allen AutorInnen bestätigte) Präregistrierungen können nicht verändert oder gelöscht werden, aber: wird innerhalb weniger Tage nach einer Präregistrierung eine neue angelegt, kann die vorherige als „Draft“ gekennzeichnet werden und wird dann durch die neue Registrierung überschrieben. Dies bietet sich an, wenn kurz nach einer Präregistrierung Fehler in dieser auffallen oder Ergänzungen gewünscht werden.

- Nützliche Ausfüllhinweise und FAQ werden bereitgestellt.

-

- Link: https://osf.io/

- OSF (Open Science Forum) ist ein Online-Repositorium für Forschungsprojekte.

- Zu jedem in OSF angelegten Forschungsprojekt kann (können) eine (oder mehrere) Präregistrierung(en) angelegt werden.

- Zahlreiche Registrierungs-Templates sind verfügbar, sie erlauben unterschiedliche Grade an Flexibilität vs. Standardisierung (z. B. maximal flexible „Open Ended Registration“ oder hoch-standardisierte „Pre-Registration in Social Psychology“; auch AsPredicted-Vorlage als Template verfügbar.

- Nützliche Informationen und Ausfüllhinweise durch OSF verfügbar.

-

- Link: https://www.psycharchives.org/en/item/088c79cb-237c-4545-a9e2-3616d6cc8453

- Präregistrierung von Studien auf der Plattform PreReg in Psychology, bereitgestellt durch das ZPID: Das Template „PRP-Quant“ wird heruntergeladen, ausgefüllt und anschließend auf die Plattform PsychArchives hochgeladen.

- PRP-Quant stellt eine ausführliche Vorlage zur Erstellung von Präregistrierungen als Ergebnis einer internationalen Taskforce verschiedener psychologischer Gesellschaften dar (u.a. DGPs, APA, BPS).

- PRP-Quant gibt 45 Fragen vor anhand derer detaillierte Aspekte der Theorie (inkl. Hypothesen), der Methodik und der geplanten Auswertung festgelegt werden. Zusätzlich zur ausgefüllten Vorlage müssen beim Hochladen in das Repositorium diverse Meta-Daten angegeben werden.

- Nützliche Informationen und Ausfüllhinweise sind in Form eines Webinars verfügbar.

-

AsPredicted OSF PreReg Strukturierung/Standardisierung hoch template-abhängig (sehr) hoch Repositorium Internet Archive

Open Science Forum (OSF) Storage (USA oder Deutschland)

PsychArchives Host Wharton Credibility Lab

(University of Pensylvania)

Center for Open Science ZPID

(Leibniz-Institut für Psychologie)

Anmeldemodalitäten Nur E-Mail-Adresse ORCID oder OSF-Account

(kostenfrei)

ORCID oder Leibniz Psychology Account

(kostenfrei)

Präregistrierung nach Abschluss der Datenerhebung möglich?

[ ❌ ]

(teilw. praktiziert, nicht empfohlen)

✔️

✔️

Einzelaspekte registrierbar?

(z. B. nur Hypothesen)

❌ ✔️

[ ❌ ]

(manuell können Teile aus der Vorlage vor dem Hochladen gelöscht werden)

Anonymisierbar?

(z. B. für blinded review)

✔️

✔️

[ ✔️ ]

(nur manuell möglich durch Entfernen der Namen aus dem Template)

Bestätigung durch alle AutorInnen 6 Tage 48 Stunden Nicht erforderlich Ohne Bestätigung Registrierung verfällt

(Zustimmungs-Regelung)

Registrierung erfolgt

(Widerspruchs-Regelung)

N/A ´DOI verfügbar ❌ ✔️

✔️

Entwurfs-Modus ✔️

(bei "self-destruct" Option verfällt die Registrierung nach 24 h)

✔️

("delete draft" Option vor Abschluss der Registrierung)

✔️

Nicht abgelossene Registrierungen verfallen nach 62 Tagen

Replication Research

-

Das folgende Review-Papier sowie die dazugehörigen Kommentare bieten darüber hinaus eine umfassende Übersicht über unterschiedliche Perspektiven auf das Thema Replikation:

Zwaan, R. A., Etz, A., Lucas, R. E., & Donnellan, M. B. (2017). Making replication mainstream. The Behavioral and Brain Sciences, 41, e120. https://doi.org/10.1017/S0140525X17001972

A) Was ist die Replikationskrise und warum sind Replikationen (weiterhin) notwendig?

Die Psychologie befindet sich aktuell in einer multiplen Krise, die durch fehlende Replikationserfolge, die Vernachlässigung kultureller und zeitlicher Variationen sowie unzureichend entwickelte Theorien gekennzeichnet ist. Hutmacher und Franz (2025) argumentieren, dass diese Krisen miteinander verknüpft sind und ihre Wurzeln in der grundlegenden Vagheit psychologischer Konzepte liegen. Psychologische Konzepte sind demnach nicht präzise definierbar, da ihre Bedeutung und Anwendung immer kontextabhängig sind. Diese Vagheit führt nicht zur Bedeutungslosigkeit psychologischer Konzepte, sondern erschwert die Suche nach festen Kriterien zur eindeutigen Definition. Aus dieser Perspektive ergeben sich Konsequenzen für die Replikationskrise. Die Autor*innen kritisieren den Fokus auf direkte oder konzeptionelle Replikationen und betonen die Bedeutung des Kontextes für die Interpretation psychologischer Phänomene. Aufgrund der Kontextgebundenheit psychologischer Konzepte ist es schwierig, universelle Effekte zu replizieren. Selbst bei scheinbar identischen Studien können kulturelle, zeitliche oder andere Kontextfaktoren zu unterschiedlichen Ergebnissen führen. Hutmacher und Franz empfehlen, den Fokus auf die Kontextbedingungen zu legen, unter denen psychologische Realitäten und das Wissen darüber entstehen. Qualitative Methoden könnten dabei helfen, die subjektiven Wahrnehmungen und Interpretationen von Forscher*innen und Teilnehmer*innen besser zu verstehen. Zusammenfassend betonen die Autor*innen, dass psychologische Forschung nicht einfach eine objektive Realität abbildet, sondern diese aktiv mitgestaltet. Die Reflexion über die eigene Position und die verwendeten Methoden ist daher essenziell, um die Komplexität psychologischer Phänomene angemessen zu berücksichtigen.

B) Replikationen helfen bei der Theorieentwicklung.

Traditionell werden Replikationen als Mittel zur Bestätigung oder Widerlegung der Ergebnisse einer Originalstudie angesehen. Dieser Ansatz greift jedoch zu kurz, da er die komplexe Natur des wissenschaftlichen Fortschritts nicht berücksichtigt.

Direkte Replikationen versuchen, die Bedingungen der Originalstudie so genau wie möglich nachzubilden, während konzeptionelle Replikationen die grundlegende theoretische Logik der ursprünglichen Studie beibehalten, aber unterschiedliche Verfahren oder Operationalisierungen von Variablen verwenden. Beide Arten von Replikationen erfordern umfangreiche theoretische Vorarbeiten, um aussagekräftige Ergebnisse zu erzielen. Eine erfolgreiche direkte Replikation zeigt lediglich die Wiederholbarkeit des Messverfahrens, nicht unbedingt dessen Genauigkeit oder die Gültigkeit der zugrunde liegenden Theorie. Die Autorin des Papers "The Role of Replication Studies in Theory Building" (Irvine, 2021) argumentiert, dass in vielen Bereichen der Psychologie noch keine ausreichende Theorieentwicklung vorhanden ist, um aussagekräftige Replikationen durchzuführen. Sie verweist auf die Philosophie der Wissenschaft, die nahelegt, dass wissenschaftlicher Fortschritt in einem kohärenten Prozess stattfindet, in dem Theorie und Experiment Hand in Hand gehen und sich langsam selbst korrigieren und schlägt daher eine alternative Perspektive vor: Replikationsversuche als explorative Studien zu betrachten, die verschiedene Stadien der Theorieentwicklung unterstützen. Diese Studien können Theorien erstellen, Hypothesen generieren, Theorien testen und verfeinern sowie experimentelle Kontrollen verbessern. Dieser iterative Prozess ermöglicht die Bereicherung und Selbstkorrektur der Theorie. Er kann temporäre Umwege erfordern, um spezifische Fragen mit begrenzten theoretischen Implikationen zu beantworten. Die Autorin betont die Vorteile dieses explorativen Ansatzes: Er fördert Entdeckungen, verbessert die Robustheit von Forschungsergebnissen und trägt zur Theorieentwicklung bei. Replikationsversuche sollten also nicht als alleinige Prüfsteine für die Gültigkeit von Forschungsergebnissen angesehen werden. Stattdessen sollten sie als explorative Studien verstanden werden, die einen wertvollen Beitrag zur kumulativen wissenschaftlichen Erkenntnis leisten.

Dieser Ansatz fördert die Zusammenarbeit und den Austausch zwischen Forscher*innen und ermöglicht es der Psychologie, komplexe Phänomene besser zu verstehen und zu erklären.

C) Bisheriger Erfolg von Replikationen

In einer systematischen Analyse von über 14.000 wissenschaftlichen Artikeln aus der Psychologie beleuchten Youyou et al. (2023) die erhebliche Variabilität der Replikationswahrscheinlichkeit zwischen verschiedenen Teilgebieten der Disziplin. Ihre Ergebnisse zeigen, dass Studien in der Persönlichkeitspsychologie (M = 0.55) und Organisationspsychologie (M = 0.50) deutlich höhere Erfolgsraten bei der Replikation erzielen als Studien der Entwicklungspsychologie (M = 0.36) und Klinischen Psychologie (M = 0.44). Ein besonders interessanter Befund ist, dass nicht- experimentelle Studien (M = 0.50) innerhalb der einzelnen Teilgebiete tendenziell besser replizierbar sind als experimentelle Studien (M = 0.39). Dies könnte darauf hindeuten, dass bestimmte methodische Ansätze oder Forschungsdesigns anfälliger für Replikationsprobleme sind. Darüber hinaus zeigen die Analysen eine positive Korrelation zwischen dem Replikationserfolg und der Erfahrung sowie der wissenschaftlichen Expertise der Autor*innen, gemessen an ihrer Publikationshistorie (bi-serielle Korrelation r = 0.17, p = .008) und der Häufigkeit, mit der sie zitiert werden (r = 0.19, p = .004). Die Analyse ergab zudem, dass weder das institutionelle Prestige der Autor*innenuniversitäten, noch die Medienberichterstattung über die Forschungsarbeiten die Replikationssicherheit signifikant vorhersagen konnten. Dies unterstreicht die Bedeutung einer gründlichen methodischen Auswahl und der Expertise der Forscher*innen für die Robustheit und Zuverlässigkeit wissenschaftlicher Erkenntnisse.

-

Diskussionen zur Auswahl von Replikationsstudien berücksichtigen verschiedene Kriterien. Einige Argumente zielen darauf ab, vor allem wertvolle Forschungsthemen zu replizieren, die einen hohen Impact für wissenschaftliche Theorien, klinische Praxis oder öffentliche Politik haben können. Andere Diskussionen konzentrieren sich auf die Unsicherheit des Forschungsstandes zu der zu replizierenden Behauptung in der aktuellen Literatur. Weitere Argumente sind die Qualität des Forschungsdesigns in der Originalstudie und die Machbarkeit der Replikation.

In dem Paper von Isager et al. (2023) wird ein quantitatives Vorgehen zur Auswahl von Replikationsstudien beschrieben. Ziel des Vorgehens ist es, den Nutzen wissenschaftlicher Aussagen nach der Replikation zu maximieren. Das Modell berücksichtigt den Wert der Forschungshypothesen, die Unsicherheit vor und nach der Replikation sowie die Kosten der Replikation. Der Wert einer Forschungshypothese hängt von ihrer Bedeutung und ihrem potenziellen Einfluss ab. Die Unsicherheit wird als Wahrscheinlichkeit ausgedrückt, dass die Forschungshypothese zutrifft. Eine gut gestaltete Replikation soll die Unsicherheit verringern und den erwarteten Nutzen der wissenschaftlichen Aussage erhöhen.

-

A) The Replication Recipe

Dieser Leitfaden basiert auf dem Paper von Brandt et al. (2014), “The Replication Recipe: What makes for a convincing replication?”. Das Paper beschreibt ein schrittweises Vorgehen bei der Durchführung von (direkten) Replikationsstudien und benennt dabei die folgenden fünf wichtigen Schritte:

1. Sorgfältige Definiton der Effekte und Methoden, die repliziert werden sollen:

Bevor eine Replikationsstudie durchgeführt wird, sollten Forscher*innen genau festlegen, welchen Effekt sie replizieren möchten. Dies umfasst die Größe des ursprünglichen Effekts, die Konfidenzintervalle und die Methoden, die zur Entdeckung des Effekts verwendet wurden. Dafür kann es notwendig sein, die Autor*innen der Originalstudie zu kontaktieren. Zusätzlich sollten Forscher*innen die theoretische und praktische Bedeutung des Effekts sowie die Zuverlässigkeit bestehender Replikationen berücksichtigen, um die besten Ressourcenentscheidungen zu treffen.

2. Exakte Umsetzung der Methoden der Originalstudie:

Die Methoden der Replikationsstudie sollten sich so genau wie möglich an der Originalstudie orientieren, einschließlich der Stichprobenrekrutierung, der Instruktionen, des Stimulusmaterials, der Messverfahren und der Analysen. Da eine ‘perfekte’ Replikation aufgrund unvermeidlicher Unterschiede nicht möglich ist, sollten Abweichungen minimiert, dokumentiert und begründet werden.

Forscher*innen sollten die Autor*innen der Originalstudie kontaktieren, um Materialien zu erhalten und die Methoden bestmöglich zu rekonstruieren. Bei kulturell oder historisch gebundenen Studien sollten die Materialien angepasst werden, um die gleiche psychologische Situation zu erfassen. Unterschiede zwischen der Original- und der Replikationsstudie sollten identifiziert und begründet werden.

3. Hohe statistische Power:

Eine Replikation sollte über ausreichende statistische Power verfügen, um eine hohe Wahrscheinlichkeit zu gewährleisten, den Effekt der Originalstudie zu entdecken. Unterpowerte Replikationsversuche können fälschlicherweise nahelegen, dass ursprüngliche Effekte falsch positiv sind. Eine statistische Power von mindestens .80 bis .95 wird empfohlen. Da die Effektgrößen in der veröffentlichten Literatur oft überschätzt werden, sollten Forscher*innen konservativ vorgehen und höhere Power-Niveaus anstreben.

4. Vollständige Offenlegung der Replikationsdetails, damit andere Forscher*innen die Replikation bewerten oder selbst durchführen können:

Um Replikationsversuche bestmöglich bewerten zu können, sollten vollständige Details zu den Methoden, Analysen und Ergebnissen der Replikation verfügbar gemacht werden. Eine Möglichkeit, dies zu erreichen, ist die Präregistrierung der Replikationsversuche, einschließlich der Methoden, Unterschiede zur Originalstudie und der geplanten Analyse. Nach Abschluss der Studie sollten die Daten und Analysen zugänglich gemacht werden.

5. Kritische Bewertung und Vergleich der Replikationsergebnisse mit den Ergebnissen der Originalstudie:

Die Ergebnisse von Replikationsstudien sollten kritisch mit den Ergebnissen der Originalstudie verglichen werden. Es reicht nicht aus, nur basierend auf der Signifikanz zu beurteilen, ob die Replikation erfolgreich war oder nicht.

Stattdessen sollten Effektgrößen und Konfidenzintervalle berechnet und statistisch mit den ursprünglichen Effektgrößen verglichen werden. Mehrere Replikationsversuche in verschiedenen Labs können helfen, die Effektgröße genauer zu schätzen und die Faktoren zu identifizieren, die die Ergebnisse beeinflussen.

Zusätzlich enthält das Paper eine Checkliste mit 36 Fragen, die bei der Planung und Kommunikation einer Replikationsstudie berücksichtigt werden sollten. Diese Fragen helfen dabei den Durchführungsprozess der Replikationsstudie zu reflektieren und Abweichungen von den fünf oben beschriebenen Schritten zu erkennen und zu begründen.

B) Interkulturelle Replikationen

Dieser Leitfaden basiert auf der Veröffentlichung von Jarke et al. (2022), „A roadmap to large-scale multi-country replications in psychology“. In diesem Paper bringen Jarke und Kolleg*innen Forscher*innen aus verschiedenen internationalen Initiativen zusammen, um Ansätze für großangelegte multinationale Replikationen zu skizzieren und die dabei gewonnenen Erkenntnisse zu teilen. Zu den beteiligten Initiativen gehören das Junior Researcher Programme (JRP; https://jrp.pscholars.org/), der Psychological Science Accelerator (PSA; https://psysciacc.org/), ManyBabies (https://manybabies.org/), Collaborative Open-science REsearch (CORE; https://osf.io/), und die International Study of Metanorms (ISMN; https://www.globalsocialnorms.org/international-study-of-metanorms).

Interkulturelle Replikationen spielen eine entscheidende Rolle in der globalen Wissenschaft, indem sie ermöglichen, Forschungsergebnisse in unterschiedlichen kulturellen Kontexten zu überprüfen und zu validieren. Diese Art von Studien bietet die Möglichkeit, Erkenntnisse auf internationaler Ebene zu vergleichen und zu vertiefen, was zu fundierteren Schlussfolgerungen führt. Der Leitfaden stützt sich auf die gesammelten Erfahrungen und bewährten Methoden dieser Initiativen. Er soll dabei helfen, erfolgreiche und methodisch fundierte Studien über verschiedene Länder und Kulturen hinweg durchzuführen.

Projektplanung und Zusammenarbeit:

Die Planung einer interkulturellen Replikation beginnt mit einer sorgfältigen Projektplanung und der Auswahl von internationalen Partner*innen. Klare Kommunikationswege und ein verantwortungsvolles Projektmanagement sind entscheidend, um die Zusammenarbeit über geografische und kulturelle Grenzen hinweg zu erleichtern.

Methodische Herangehensweise:

Bei der Auswahl der Methoden sollten eine Anpassung an unterschiedliche kulturelle Kontexte erfolgen. Dies beinhaltet die Übersetzung und Anpassung von Forschungsmaterialien sowie die Berücksichtigung ethischer und rechtlicher Aspekte, wie z.B. Datenschutzbestimmungen.

Datenerhebung und -analyse:

Die Datenerhebung erfolgt entweder zentral oder durch individuelle Forschungsteams in den jeweiligen Ländern. Es ist wichtig, nationale Datenschutzgesetze zu beachten und sicherzustellen, dass die gesammelten Daten sicher und ethisch einwandfrei behandelt werden.

Berichterstattung und Verbreitung von Ergebnissen:

Nach Abschluss der Studie sollten die Ergebnisse klar und verständlich in verschiedenen Sprachen kommuniziert werden. Dies ermöglicht es, länderspezifische Erkenntnisse hervorzuheben und die Ergebnisse sowohl in wissenschaftlichen Kreisen als auch der breiteren Öffentlichkeit zugänglich zu machen.

Ethik und Transparenz:

Ethik und Transparenz sind in interkulturellen Replikationsstudien von zentraler Bedeutung. Alle Schritte sollten darauf ausgerichtet sein, die Integrität der Forschung zu wahren und die Teilnahme der Beteiligten zu respektieren.

Abschlussbemerkungen:

Interkulturelle Replikationen bieten eine einzigartige Möglichkeit, Forschungsergebnisse weltweit zu validieren und zu vertiefen. Mit einer klaren Planung, sorgfältigen methodischen Überlegungen und einer engagierten internationalen Zusammenarbeit kann ein Beitrag zu einem umfassenderen Verständnis komplexer sozialer und psychologischer Phänomene geleistet werden.

Für weitere Ressourcen und Anleitungen gibt es ein Online-Repository der Autor*innen.

-

Im Folgenden sind Auszüge aus den Richtlinien der einzelnen Journals aufgelistet. Des Weiteren ist vermerkt, ob Registered Replication Reports und/oder Replikationen erwünscht sind (Stand: Oktober 2024).

Advances in Methods and Practices in Psychological Science

https://www.psychologicalscience.org/publications/ampps/ampps-submission-guidelines#INFO

Registered Replication Reports (RRRs)

“A Registered Replication Report is a special type of registered report that describes the meta-analytic result of a set of independently conducted direct replications of an important original study. These replications all follow a preapproved, preregistered protocol and analysis plan. The decision about whether or not to launch an RRR involves a multistage process to determine (a) whether the original study has high replication value, (b) whether the results would be of broad interest regardless of the outcome, and (c) whether enough laboratories could participate given the resources available. If the editors determine that an RRR would be of value, the submission process works much like that for an Empirical Article that is a registered report. The introduction and General Discussion sections for RRRs should be brief, objective, and focused on the study under investigation. RRR manuscripts should not include extensive speculation or theorizing. For more information about RRRs, see Simons and Holcombe (2014). Introductions should be concise (< 1,500 words) and focused on the motivations for conducting the replication study rather than a review of the broader literature. General Discussion sections should be brief (500–1,000 words).”

Collabra Psychology

https://online.ucpress.edu/collabra/pages/journalpolicies

Replication

“Psychology welcomes submissions of replication studies.”

Journal of Experimental Psychology

https://www.apa.org/pubs/journals/xge

Replication

“The journal values the replication and extension of key results within an article when possible, as an excellent means to demonstrate the reliability and generality of results. Internal replication is encouraged even for brief reports, through succinct reporting and/or the use of electronic supplementary materials. The journal publishes replication articles, including contributions with interdisciplinary appeal that address theoretical debate and/or integration. Replication submissions should include “A Replication of [study citation]” in the subtitle of the manuscript as well as in the abstract.”

Journal of Personality and Social Psychology

https://www.apa.org/pubs/journals/psp

Replication and Registered Reports

“Journal of Personality and Social Psychology acknowledges the significance of replication in building a cumulative knowledge base in our field. We therefore encourage submissions that attempt to replicate important findings, especially research previously published in Journal of Personality and Social Psychology. Major criteria for publication of replication papers include (i) theoretical significance of the finding being replicated, (ii) statistical power of the study that is carried out, and (iii) the number and power of previous replications of the same finding. Other factors that would weigh in favor of a replication submission include: pre- registration of hypotheses, design, and analysis; submissions by researchers other than the authors of the original findings; and attempts to replicate more than one study of a multi-study original publication. Please note in the Manuscript Submission Portal that the submission is a replication article; submissions should include “A Replication of XX Study” in the subtitle of the manuscript as well as in the abstract. Replication manuscripts, if accepted, will be published online only and will be listed in the Table of Contents in the print journal. Papers that make a substantial novel conceptual contribution and also incorporate replications of previous findings continue to be welcome as regular submissions.”

Personality and Individual Differences

https://www.sciencedirect.com/journal/personality-and-individual-differences

Replication

“Replication Studies: The editors of PAID strongly believe that highly powered replication studies are essential to good science. We especially encourage authors to submit strong replication attempts of studies that were published in PAID. Authors who conduct replication studies should assume that effect sizes will likely not be as large as those published in the original paper, and they should choose sample sizes that have more than adequate power to detect this expected effect. Furthermore, authors should calculate confidence intervals around their estimated effects and compare them to the original effect size and to the null hypothesis when reporting their results.”

Psychological Science

https://www.psychologicalscience.org/publications/psychological_science/ps-submissions

Replication

“Replication studies, generalizability tests, and other verification work can meet these criteria. If a published study is of general interest, has theoretical and empirical significance, and there is appreciable uncertainty about the results, then a high quality study testing the replicability or generalizability of the effect may also meet the criteria for publication.”

Psychology and Aging

https://www.apa.org/pubs/journals/pag

Replication

"Psychology and Aging publishes direct replications. Submissions should include “A Replication of XX Study” in the subtitle of the manuscript as well as in the abstract."

Social Psychology

https://www.hogrefe.com/us/journal/social-psychology

Replication

"Social Psychology publishes innovative and methodologically sound research and serves as an international forum for scientific discussion and debate in the field of social psychology. Topics include all basic social psychological research themes, methodological advances in social psychology, as well as research in applied fields of social psychology. The journal focuses on original empirical contributions to social psychological research, but is open to theoretical articles, critical reviews, and replications of published research."

Beispielartikel der einzelnen Journals zur Orientierung

a) Journal of Social Psychology

- Direkte Replikation:

- George-Levi, S., Laslo-Roth, R., & Schmidt-Barad, T. (2021). Feeling you, when you feel me: attachment, empathic concern, and interpersonal emotion regulation. The Journal of Social Psychology, 162(6), 655–669. https://doi.org/10.1080/00224545.2021.1940075

- Rice, D. B., Letwin, C., Taylor, R., & Wo, X. (2020). Extending the trickle-down model of abusive supervision. The role of moral disengagement. The Journal of Social Psychology, 161(1), 40–46. https://doi.org/10.1080/00224545.2020.1752133

- Konzeptuelle Replikation:

-

Otterbring, T., Bhatnagar, R., & Folwarczny, M. (2022). Selecting the special or choosing the common? A high-powered conceptual replication of Kim and Markus’ (1999) pen study. The Journal of Social Psychology, 164(2), 244–250. https://doi.org/10.1080/00224545.2022.2036670

-

b) Journal of Psychology and Aging

- Direkte Replikation:

- Nicosia, J., & Balota, D. (2020). The consequences of processing goal- irrelevant information during the Stroop task. Psychology and Aging, 35(5), 663. http://dx.doi.org/10.1037/pag0000371

- Konzeptuelle Replikation:

- Campbell, K. L., & Hasher, L. (2018). Hyper-binding only apparent under fully implicit test conditions. Psychology and Aging, 33(1), 176. http://dx.doi.org/10.1037/pag0000216

- Choi, Y., Lay, J., Lu, M., Jiang, D., Peng, M., Fung, H. H., Graf, P., & Hoppmann, C. A. (2024). Age differences in the experience of everyday happiness: The role of thinking about the future. Psychology and Aging, 39(1), 1–13. https://doi.org/10.1037/pag0000782

c) Journal of Personality and Individual Differences

- Direkte Replikation:

- Leslie-Evans, M., Bartschi, J. G., & Allen, M. S. (2022). Dark personality traits and sociosexual dynamics in Australian men and women: Two direct replications of Borráz-León & Rantala (2021). Personality and Individual Differences, 196, 111753. https://doi.org/10.1016/j.paid.2022.111753

- Konzeptuelle Replikation:

- Liu, K., Wright, M. E., Cole, L. A., & Warren, S. L. (2024). Bi-factor model of repetitive thinking: Replication and extension. Personality and Individual Differences, 226, 112692. https://doi.org/10.1016/j.paid.2024.112692

- Registered Report:

- Richards, G., Newman, M., Butler, A., Lechler-Lombardi, J., Osu, T., Krzych-Miłkowska, K., & Galbarczyk, A. (2023). Birth order, personality, and tattoos: A pre-registered empirical test of the ‘born to rebel’hypothesis. Personality and Individual Differences, 204, 112043. https://doi.org/10.1016/j.paid.2022.112043

d) Journal of Personality and Social Psychology

- Direkte Replikation:

- Genschow, O., Westfal, M., Crusius, J., Bartosch, L., Feikes, K. I., Pallasch, N., & Wozniak, M. (2021). Does social psychology persist over half a century? A direct replication of Cialdini et al.’s (1975) classic door-in-the-face technique. Journal of Personality and Social Psychology, 120(2), e1. http://dx.doi.org/10.1037/pspa0000261

- Konzeptuelle Replikation:

- Layous, K., Kumar, S. A., Arendtson, M., & Najera, A. (2023). The effects of rumination, distraction, and gratitude on positive and negative affect. Journal of Personality and Social Psychology, 124(5), 1053–1078. https://doi.org/10.1037/pspp0000440

- Registered Report:

- Weston, S. J., Condon, D. M., Rentfrow, P. J., & Benet-Martínez, V. (2024). The person-environment fit of immigrants to the United States: A registered report.Journal of Personality and Social Psychology, 126(5), 873–894. https://doi.org/10.1037/pspp0000504

e) Advances in Methods and Practices in Psychological Science

- Direkte Replikation:

- Ghelfi, E., Christopherson, C. D., Urry, H. L., Lenne, R. L., Legate, N., Ann Fischer, M., ... & Sullivan, D. (2020). Reexamining the effect of gustatory disgust on moral judgment: A multilab direct replication of Eskine, Kacinik, and Prinz (2011). Advances in Methods and Practices in Psychological Science, 3(1), 3-23. https://doi.org/10.1177/2515245919881152

- Konzeptuelle Replikation:

- Vaidis, D. C., Sleegers, W. W., Van Leeuwen, F., DeMarree, K. G., Sætrevik, B., Ross, R. M., ... & Priolo, D. (2024). A multilab replication of the induced-compliance paradigm of cognitive dissonance. Advances in Methods and Practices in Psychological Science, 7(1). https://doi.org/10.1177/25152459231213375

- Registered Report:

- Colling, L. J., Szűcs, D., De Marco, D., Cipora, K., Ulrich, R., Nuerk, H. C., ... & McShane, B. B. (2020). Registered replication report on fischer, castel, dodd, and pratt (2003). Advances in Methods and Practices in Psychological Science, 3(2), 143-162. https://doi.org/10.1177/2515245920903079

f) Collabora: Psychology

- Direkte Replikation:

- Tsuji, N., & Imaizumi, S. (2024). Order effects on the rubber hand illusion expectancy: A replication and extension of Lush (2020). Collabra: Psychology, 10(1). https://doi.org/10.1525/collabra.116190

- Konzeptuelle Replikation:

- Liu, D., & Giner-Sorolla, R. (2024). Bad people alert: The expression of disgust signals its target’s bad moral character. Collabra: Psychology, 10(1). https://doi.org/10.1525/collabra.116193

- Registered Report:

- Giessner, S. R., & Schubert, T. W. (2019). Power and vertical positions in an organization chart: A Pre-registered replication report of study 3a and a modification of study 1a, Giessner & Schubert (2007). Collabra: Psychology, 5(1), Article 25. https://doi.org/10.1525/collabra.216

g) Psychological Science

- Direkte Replikation/Konzeptuelle Replikation/Registered Report:

- Robertson, C. E., Akles, M., & Van Bavel, J. J. (2024). Preregistered Replication and Extension of “Moral Hypocrisy: Social Groups and the Flexibility of Virtue”. Psychological Science, 0(0). https://doi.org/10.1177/09567976241246552

- Direkte Replikation:

- Vaughan-Johnston, T. I., Jacobson, J. A., Prosserman, A., & Sanders, E. (2021). Mind-Body Practices and Self-Enhancement: Direct Replications of Gebauer et al.’s (2018) Experiments 1 and 2. Psychological Science, 32(9), 1510-1521. https://doi.org/10.1177/0956797621997366

- Konzeptuelle Replikation:

- Imhoff, R., Müller, B. C. N., & Heidrich, V. (2024). Do They Look the Same Unless They Are Angry? Investigating the Other-Race Effect in the Presence of Angry Expressions. Psychological Science, 35(4), 405-414. https://doi.org/10.1177/09567976231218640

- Registered Report:

- Vohs, K. D., Schmeichel, B. J., Lohmann, S., Gronau, Q. F., Finley, A. J., Ainsworth, S. E., Alquist, J. L., Baker, M. D., Brizi, A., Bunyi, A., Butschek, G. J., Campbell, C., Capaldi, J., Cau, C., Chambers, H., Chatzisarantis, N. L. D., Christensen, W. J., Clay, S. L., Curtis, J., … Albarracín, D. (2021). A Multisite Preregistered Paradigmatic Test of the Ego-Depletion Effect. Psychological Science, 32(10), 1566-1581. https://doi.org/10.1177/0956797621989733

- Direkte Replikation:

Reproducible Analyses

-

Die folgenden Empfehlungen basieren auf den 'Recommendations for Good Enough Scientific Computing' (Wilson et al., 2017).

Aus dem Abstract: „Computers are now essential in all branches of science, but most researchers are never taught the equivalent of basic lab skills for research computing. […] Computing workflows need to follow the same practices as lab projects and notebooks, with organized data, documented steps, and the project structured for reproducibility […]. This paper presents a set of good computing practices that every researcher can adopt, regardless of their current level of computational skill.” (Wilson et al., 2017)

Datenmanagement:

- Die Rohdaten zu jedem Forschungsvorhaben sollten gespeichert werden. Rohdaten sollten durch Backups gesichert werden, damit die Wahrscheinlichkeit, dass sie komplett verloren gehen, minimiert wird.

- Die Datenverarbeitungsschritte sollten nachvollziehbar sein. Alle Schritte und Anwendungen, die mit den Rohdaten durchgeführt wurden, sollten protokolliert werden, etwa im Code des Analyseskripts.

- Die Daten sollten 'tidy' sein.

- Variablennamen sollten zwischen verschiedenen Datensätzen des gleichen Projektes konsistent verwendet werden.

- Datensätze sollten nach Möglichkeit veröffentlicht werden, z. B. über FigShare.

Software:

- Der Code sollte in einem angemessenen Maße kommentiert sein, damit auch andere nachvollziehen können, was der Code macht.

- Der Code sollte nach Möglichkeit dedupliziert werden und effizient geschrieben werden.

- Funktionen und Variablen sollten eindeutige, verständliche und konsistente Namen haben.

- Der Code sollte veröffentlicht werden.

Kollaboration:

- Zu jedem Projekt sollte es eine Projektübersicht, eine To-Do-Liste und eine Verwendungslizenz geben.

- Innerhalb eines Projektes sollte sich auf eine Kommunikationsstrategie geeinigt werden: Wie werden Dateien geteilt und wie wird das gemeinsame Vorgehen geklärt?

Projektorganisation:

- Für jedes Projekt bietet es sich an, einen eigenen Ordner zu erstellen.

- Als Unterordner empfehlen sich "Daten", "Ergebnisse" und "Dokumente".

- Alle Dateien sollten einheitlich und verständlich benannt werden.

Versionskontrolle und Nachempfinden von Veränderungen:

- Versionskontrolle sollte systematisch verwendet werden, z. B. über Git.

- Änderungen sollten klein im Umfang sein und häufig geteilt werden.

- Nach größeren Änderungen ist es sinnvoll, eine Kopie des Projekts zu erstellen. Versionskontrollsysteme machen dies automatisch.

-

VSCode:

- Link: https://code.visualstudio.com/

- Kostenfreier, Open-Source-Text- und Code-Editor von Microsoft.

- Unterstützt zahlreiche Programmiersprachen (u. a. R, Python, Markdown, LaTeX).

- Erweiterbar durch eine schier unendliche Anzahl von Erweiterungen für fast jeden Use Case.

- Integrierte Git-Unterstützung ermöglicht eine einfache Versionskontrolle und die Nachverfolgung von Änderungen.

- Ideal zur Bearbeitung von Analyse-Skripten oder wissenschaftlichen Manuskripten in LaTeX/Markdown. Dank der guten Integration mit Git lassen sich Änderungen an Forschungsprojekten einfach transparent dokumentieren und reproduzierbar gestalten.

RStudio:

- Link: https://posit.co/download/rstudio-desktop/

- Kostenfreie, benutzerfreundliche Entwicklungsumgebung für R (und auch für Python).

- Besonders geeignet für reproduzierbare Forschung durch die Integration von R Markdown/Quarto (Dokumenterstellung) und Shiny (einen einfachen Weg, um simple Webanwendungen zu bauen).

- Insbesondere für Statistik und Datenanalyse bietet R bzw. RStudio i. d. R. die 'state of the art'-Bibliotheken.

GitHub:

- Link: https://github.com/

- Plattform für Versionskontrolle und kollaborative Arbeit mit Git.

- Ermöglicht das Speichern, Versionieren und gemeinsame Bearbeiten von Code, Daten und Texten.

- Öffentliche Repositories fördern Transparenz und Nachnutzbarkeit wissenschaftlicher Arbeit.

- Private Repositories unterstützen geschützte Teamarbeit.

- Zusätzliche Funktionen: GitHub Pages (Websites), Issues (Projektmanagement), Wikis (Dokumentation).

GitLab:

- Link: https://about.gitlab.com/

- Open-Source-Alternative zu GitHub mit ähnlichen Funktionen.

- Kann online oder lokal (z. B. auf universitätseigenen Servern) betrieben werden.

- Besonders geeignet für Projekte mit Datenschutzanforderungen oder sensiblen Daten.

- Unterstützt strukturierte und transparente Zusammenarbeit in Forschungsteams.

-

- Chao, L. (2009). Utilizing open source tools for online teaching and learning Information Science. Hershey, PA: Information Science Reference.

- Gandrud, C. (2016). Reproducible research with R and R Sstudio. New York: CRC Press.

- Reproducible Research in R Workshop Overview

- Reproducible Research in R

- Data Skills for Reproducible Science

Fair Data and Materials

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

Academic Life, Ethics and Culture

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

-

- Inhalte folgen -

Sonstige Materialien für Forschende

- Inhalte folgen -