Aktuelles

Computerlinguistik: Von Rechtschreibfehlern und effektiven Argumenten

[07.07.2023]Automatisches Scoring und Handschrifterkennung – zu diesen Themen wurden gleich vier Paper aus der CATALPA-Forschungsprofessur Computerlinguistik und der Nachwuchsgruppe EduNLP bei der ACL 2023 in Toronto angenommen. Das "Annual Meeting of the Association for Computational Linguistics" zählt zu den wichtigsten Konferenzen für Forschende auf diesem Gebiet.

Foto: Henrik Schipper/Hardy Welsch

Foto: Henrik Schipper/Hardy Welsch

Automatisches Scoring und Handschrifterkennung bei frei verfassten Texten von Lernenden – zu diesen Themen wurden gleich vier Paper aus der CATALPA-Forschungsprofessur Computerlinguistik und der Nachwuchsgruppe EduNLP bei der ACL 2023 in Toronto angenommen. Das "Annual Meeting of the Association for Computational Linguistics" zählt zu den wichtigsten Konferenzen für Forschende auf diesem Gebiet.

Wissenschaftskommunikatorin Christina Lüdeke sprach mit Marie Bexte, Yuning Ding und Christian Gold über ihre Forschungsergebnisse.

Christina Lüdeke: Christian, du befasst dich mit Handschriften. Was genau ist der Fokus deiner Forschung?

Christian Gold: Es geht um handschriftliche Texte mit Fehlern.Lernende machen Rechtschreibfehler, wenn sie Texte verfassen. Oder sie streichen Worte durch und schreiben andere darüber. Manchmal machen sie auch ein Sternchen und fügen neue Worte ein, die sie an einer anderen Stelle des Blattes notieren. Wenn ich all das von einer Kamera erfassen lasse, sind das erst einmal nur Pixel mit Farbinformationen. Mein Ziel war, mit Hilfe von KI alles Geschriebene Buchstabe für Buchstabe zu erfassen – und zwar mit den Rechtschreibfehlern, die die Lernenden gemacht haben.

Christina Lüdeke: Was versprichst du dir davon?

Christian Gold: Viele Lernende haben mit bestimmten Rechtschreibregeln Schwierigkeiten, manche haben auch eine Lese-Rechtschreib-Schwäche. Wenn Handschriften automatisch erkannt werden, lassen sich auch solche Fehler und Schwächen frühzeitig erkennen. Lehrende können dann gezielt fördern. Aber in diesem Bereich gibt es bisher sehr wenig Forschung. Ich habe hier sozusagen Grundlagenarbeit geleistet.

Christina Lüdeke: Aber das Thema Handschrifterkennung ist doch nicht neu…

Christian Gold: Ja, aber meistens geht es bei anderen Forschenden um das Erfassen historischer Texte, zum Beispiel von Kirchenbüchern.Und selbst wenn es mal aktuelle Texte sind – Fehler werden beim automatischen Erfassen eigentlich immer geglättet, denn in der Regel geht es um die Inhalte. Das war bei unserem Projekt anders, hier standen die Fehler im Mittelpunkt.

Foto: Juana Mari Moya/Moment/GettyImages

Foto: Juana Mari Moya/Moment/GettyImages

Christina Lüdeke: Wie seid ihr vorgegangen?

Christian Gold: Die Uni Köln hatte für ein anderes Forschungsprojekt schon eine große Anzahl von Freitexten erfasst. Allerdings ging es da eben um Inhalt, nicht um Rechtschreibung. Deshalb begann bei uns der Erfassungsprozess noch einmal von Neuem: Zwei Annotatoren haben 1.350 Texte nach einem bestimmten Schema erfasst. Denn Fehler folgen auch einer bestimmten Systematik, man verwechselt zum Beispiel die Buchstaben 'd' und 't' in einem Wort wie 'Wald'. Danach haben wir eine Art Wörterbuch für Rechtschreibfehler generiert. Wir sind von einem Wortschatz von 45.000 Wörtern ausgegangen, passend zum Lernstand in unserer Gruppe. Aber wenn man eine Vielzahl von möglichen Fehlern einbezieht, wird der Datensatz schon sehr schnell sehr groß. Unser Wörterbuch für Rechtschreibfehler umfasste dann etwa 14 Millionen Varianten dieser Wörter, weil es eben so viele Möglichkeiten gibt, etwas falsch zu schreiben.

Christina Lüdeke: Wow, das klingt ganz schön aufwändig.

Christian Gold: Ja, das war es auch, aber damit konnten wir dann wirklich fast alle falsch und richtig geschriebenen Wörter in den Handschriften erfassen, insgesamt 94 Prozent. Weil allein der Prozess des Transkribierens schon so aufwändig war, haben wir zwei Paper aus unserer Arbeit gemacht. Für eines hätte das den Rahmen gesprengt. Auf diese Grundlage können jetzt andere Forschende aufbauen, die sich mit einem ähnlichen Thema befassen.

Freitext-Essays und ihre Bewertung

Christina Lüdeke: Auch bei euch beiden, Marie und Yuning, geht es um Texte von Lernenden. Aber ihr betrachtet nicht die Rechtschreibung, sondern den Inhalt, oder?

Yuning Ding: Ja, genau. Mein Paper befasst sich mit argumentativen Essays und ihrer Bewertung, also dem Scoring. Ich selbst habe zum Beispiel Englisch als Fremdsprache gelernt und fand das freie Verfassen von Texten immer am schwierigsten. Aber hier ist es auch für die Lehrenden am aufwändigsten, Feedback zu geben. Ihre Ressourcen sind einfach limitiert. An der Stelle kann in Zukunft die Automatisierung einen wichtigen Beitrag leisten, um Lernende zu unterstützen.

Christina Lüdeke: Wie bist du vorgegangen?

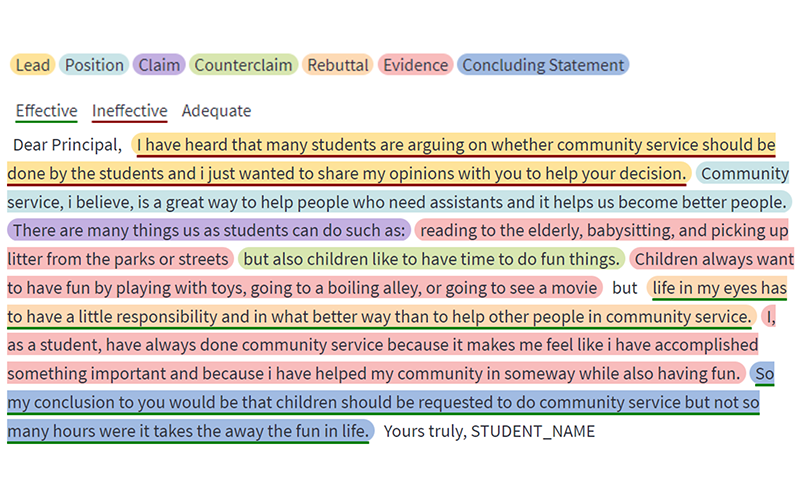

Yuning Ding: Zum einen ging es um den Aufbau der Texte, also ihre Struktur. Ein argumentatives Essay besteht unter anderem aus einer Einleitung, Behauptungen, Belegen für die Behauptungen und einer Schlussfolgerung am Ende. Das war die erste Herausforderung, dass diese Teile klar erkannt und zugeordnet wurden.

Christina Lüdeke: Und worum ging es noch?

Yuning Ding: Vor allem um eine inhaltliche Bewertung, um die Effektivität in der Argumentation. Das einzuschätzen ist ganz zentral für die Bewertung des Textes insgesamt.

Abbildung: CATALPA

Abbildung: CATALPA

Christina Lüdeke: Und diese Effektivität lässt sich tatsächlich automatisiert bewerten?

Yuning Ding: Ja, das funktioniert schon ganz gut, vor allem, wenn wir die Aufgabenstellung für die Lernenden mit einbeziehen. Zu dem Text-Datensatz, den wir benutzt haben, liegt auch jeweils die Bewertung der Lehrkraft vor. Das ist sozusagen unser Gold-Standard. Damit haben wir unser automatisches Scoring verglichen. Es funktioniert besonders gut, wenn wir die die strukturelle Bewertung der Texte und die der Effektivität miteinander verknüpfen. Damit kommen wir näher an die Bewertung der Lehrkraft heran als wenn wir beides getrennt betrachten.

Scoring-Verfahren im Vergleich

Christina Lüdeke: Du, Marie, vergleichst in deiner Arbeit verschiedene Scoring-Verfahren miteinander – "instance-based scoring" und "similarity-based scoring". Was ist da was?

Marie Bexte: Das übliche Verfahren, wenn es um das Bewerten von Freitexten geht, ist "instance-based scoring". Dafür braucht man sehr große Datensätze. Die KI vergleicht die Texte miteinander und ermittelt so eine Bewertung, also den Score, allerdings ohne dass man genau nachvollziehen kann, wie dieser zustande kommt. Beim "similarity-based scoring" gibt man dagegen gewissermaßen eine Musterlösung vor, mit der die Texte dann verglichen werden.

Christina Lüdeke: Das ist näher an dem Vorgehen einer menschlichen Lehrkraft…

Marie Bexte: Ja, und man benötigt nicht so große Datenmengen wie beim "instance-based scoring". Üblicherweise habe ich in einer Lerngruppe ja nicht Tausende von Personen, die dieselbe Aufgabe bearbeiten. Das Verfahren ist also deutlich näher an der realen Lernsituation. Die Lehrkraft kann mehr Einfluss auf die Bewertung nehmen, weil sie den Maßstab vorgibt. Außerdem gehen wir davon aus, dass die Akzeptanz bei den Lernenden für den Score höher ist, wenn sie nachvollziehen können, wie er zustande gekommen ist.

Christina Lüdeke: Klingt, als hätte das Verfahren viele Vorteile. Wie hat es denn im Vergleich abgeschnitten?

Marie Bexte: Aus einer früheren Studie hatten wir Hinweise darauf, dass beide Verfahren gleich gut abschneiden könnten. Das haben wir hier nun näher untersucht und herausgefunden, dass beide Methoden jeweils ihre Stärken und Schwächen haben. Trotzdem bleiben die Vorteile des "similarity-based scoring" natürlich bestehen. Deshalb wollen wir als nächstes einen hybriden Ansatz untersuchen, der beide Verfahren kombiniert.

Konferenz als Meilenstein

Christina Lüdeke: Du wirst ja nach Toronto fahren und dort dein Paper vorstellen und auch das von Yuning, bei dem du Co-Autorin bist. Was bedeutet das für dich?

Marie Bexte: Mit einem eigenen Paper auf so einer Top-Konferenz zu sein – das ist schon ein wichtiger Schritt in meiner wissenschaftlichen Karriere. Ich freue mich sehr darauf.

Yuning Ding: Für mich war die Arbeit, die in das Paper geflossen ist, auch ein wichtiger Meilenstein. Zu der Konferenz kann ich leider nicht, weil ich einen Forschungsaufenthalt in den USA antrete. Aber ich habe damit vielleicht ein Drittel der Arbeit für meine Dissertation geschafft, das bedeutet sehr viel für mich.

Christina Lüdeke: Und wie sieht es bei dir aus, Christian?

Christian Gold: Ich habemit dieser Arbeit den Forschungs-Teil für meine Dissertation abgeschlossen. Jetzt muss ich "nur noch" schreiben. Von daher ist die Konferenz auch für mich ganz klar ein Meilenstein.