Aktuelles

Mit neuem KI-Tool gegen Hass im Netz

[06.02.2024]Ein besseres und sichereres Internet – das ist das Ziel des „Safer Internet Day“ am 6. Februar. Dazu passt ein Projekt des Hagener Computerlinguisten Prof. Dr. Torsten Zesch: Mit seiner Hilfe entstand ein KI-Tool, das strafbare Hassbotschaften aus Social-Media-Posts erkennt. Das Tool soll die Praxis von Strafverfolgungsbehörden erleichtern. Ziel ist es, Straftaten schneller zu erkennen und damit Kriminalität besser bekämpfen zu können.

Foto: Hendrik Schipper

Foto: Hendrik Schipper

„Einsatz von KI zur Früherkennung von Straftaten (KISTRA)“ hieß das BMBF-finanzierte Projekt, bei dem Forschende von sechs Universitäten unter anderem mit dem Bundeskriminalamt (BKA) und der Zentralen Stelle für Informationstechnik im Sicherheitsbereich (ZITiS) zusammenarbeiteten. „Für uns stand dabei das linguistische Interesse im Vordergrund“, erklärt Torsten Zesch, der am Forschungszentrum CATALPA die Professur Computerlinguistik innehat. Herausforderung: Die KI muss nicht nur Hass-Posts erkennen, sondern sie auch verschiedenen Straftatbeständen zuordnen, etwa Beleidigung, Bedrohung oder Volksverhetzung. Hierfür arbeiteten Torsten Zesch und sein Team eng mit Juristinnen zusammen, unter anderem mit Prof. Dr. Frederike Zufall vom Karlsruher Institut für Technologie (KIT). Sie zerlegten die Straftatbestände in einzelne miteinander verknüpfte Bausteine, die Zesch in einen Erkennungsalgorithmus „übersetzen“ konnte. „Das hat eigentlich gut gepasst, weil Gesetze nach einer ähnlichen Logik aufgebaut sind wie Computerprogramme“, so Zesch.

Sichere Ergebnisse trotz Verfremdungen

Abbildung: CATALPA

Abbildung: CATALPA

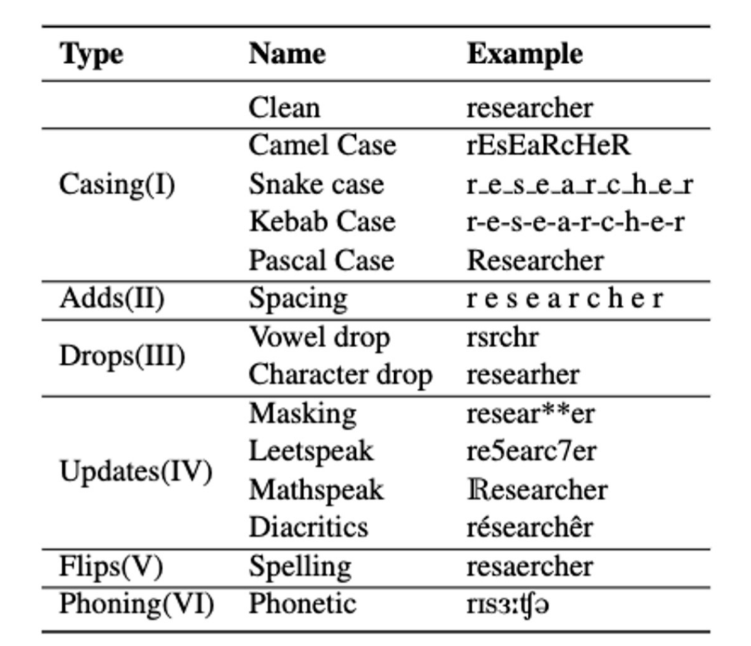

Viel schwieriger: Auch dann verlässliche Ergebnisse zu erzielen, wenn beispielsweise die Rechtschreibung in einem Hass-Post nicht stimmt oder Verfremdungen eingesetzt werden. „Das wird oft bewusst gemacht, mutmaßlich, um einer automatisierten Erkennung zu entgehen“, erklärt Zesch. Zum Beispiel werden Buchstaben weggelassen und durch Zahlen oder Sonderzeichen ersetzt. Als „Noise“ bezeichnet man in der Computerlinguistik diese Verfremdungen, also als Krach oder Lärm.

Sechs verschiedene Verfremdungs-Strategien identifizierten Torsten Zesch und sein Mitarbeiter Piush Aggarwal, teilweise mit mehreren Unter-Kategorien (siehe Abbildung rechts). Sie fanden Methoden, mit diesen Strategien umzugehen und trotzdem stabile Ergebnisse zu erhalten. „Robustheit“ oder Englisch „robustness“ ist hierfür der Fachbegriff.

Von Hate Speech zu Klausur-Bewertung

Diese Methoden aus KISTRA helfen dem Computerlinguisten auch für seine zentrale Forschung bei CATALPA weiter. Im Mittelpunkt steht hier die Sprache von Lernenden. Aktuell arbeitet er beispielsweise daran, Freitext-Antworten in Klausuren mit KI bewerten zu lassen. Auch dabei ist die „Robustheit” ein zentrales Ziel. In den meisten Uni-Klausuren sollen beispielsweise Rechtschreibfehler keine Rolle bei der Bewertung spielen. „Lernende machen solche Fehler unbewusst und aus ganz verschiedenen Gründen“, erklärt Zesch. „Zum Beispiel, weil Deutsch nicht ihre Muttersprache ist, oder es sind einfach Flüchtigkeitsfehler.“ Die KI muss in diesem Fall dennoch das inhaltlich richtige Wort erkennen. Das klappt schon recht gut: Eine erste Vorstudie mit Bachelor-Klausuren im Fach Psychologie verlief vielversprechend.

Eine weitere Herausforderung für „robuste“ Ergebnisse: die Handschriften von Lernenden. Von Hand Geschriebenes kann etwa mehr oder weniger krakelig sein. „Außerdem unterscheiden sich Handschriften je nach kulturellem Hintergrund“, sagt Zesch. „Im amerikanischen Sprachraum schreibt man beispielsweise die Ziffern 1 und 7 ganz anders als im deutschen, trotzdem muss beides in einer Klausur von der KI gleich bewertet werden.“ Die Methoden, die man dafür anwendet, ähneln denen in dem Hate-Speech-Projekt.

Entscheidungen bleiben in menschlicher Hand

Und noch eine Parallele gibt es: In beiden Fällen soll die KI den Menschen lediglich die Arbeit erleichtern. Das war bei KISTRA ganz klar gefordert: „Die Entscheidung über die Strafbarkeit liegt weiterhin bei den ermittelnden Beamtinnen und Beamten“, erklärt Zesch. Und auch die endgültige Klausur-Bewertung soll weiterhin in menschlicher Hand bleiben, die KI dient dabei lediglich als Hilfsmittel.

KI in der Sicherheitsforschung

Das Projekt KISTRA war Teil des Rahmenprogramms „Forschung für die zivile Sicherheit“ der Bundesregierung in der Förderrichtlinie „Künstliche Intelligenz in der Sicherheitsforschung“. Seit Anfang 2024 läuft die vierte Phase des Rahmenprogramms.