Aktuelles

CATALPA Lecture Series: Tanja Käser über Bildungstechnologien und Lernmodelle

[22.01.2026]Verallgemeinerbarkeit versus Interpretierbarkeit von Lernmodellen - darum ging es im Vortrag von Tanja Käser im Rahmen der CATALPA Lecture Series am 21. Januar. In der Bildungstechnologie sind Wissens- und Verhaltensmodelle zentral, doch oft mangelt es entweder an Generalisierbarkeit oder Interpretierbarkeit dieser. Wie KI hier eingesetzt werden kann, das untersuchen Käser und ihr Team.

Foto: CATALPA

Foto: CATALPA

Einblicke in die Wissenschaft von internationalen Kolleg*innen und Anlass zum Austausch - das ist das Ziel der "CATALPA Lecture Series". Beim nächsten Mal zu Gast: Prof. Dr. Tanja Käser. Sie ist Assistant Professor mit Tenure Track an der EPFL School of Computer and Communication Sciences (IC) in Lausanne und leitet dort das ML4ED-Labor (Machine Learning for Education Laboratory). Ihre Forschung liegt an der Schnittstelle von maschinellem Lernen, Data Mining und Bildung. Sie interessiert sich besonders für die Erstellung genauer Modelle des menschlichen Verhaltens und Lernens.

Abstract

Im Zentrum der Bildungstechnologie steht die Modellierung von Wissen, Verhalten und Strategien von Lernenden. Lernmodelle bilden die Basis, um Lernerfahrung an die Bedürfnisse von Lernenden anpassen zu können und unterstützen Lehrende bei der Gestaltung des Unterrichts. Ein Großteil der Forschung hat sich darum bisher auf die Erstellung möglichst genauer Wissens- und Verhaltsmodelle von Lernenden konzentriert. Die derzeitigen Modellierungsansätze sind jedoch noch begrenzt: Entweder sind sie für spezifische und gut strukturierte Bereiche (z. B. Algebra, Vokabellernen) definiert, was einen erheblichen Aufwand von Expert*innen erfordert und die Verallgemeinerbarkeit einschränkt, oder es mangelt an Interpretierbarkeit. Jüngste Fortschritte in der generativen KI, insbesondere bei großen Sprachmodellen (LLMs), haben das Potenzial, diese Einschränkungen zu überwinden. Allerdings mangelt es LLMs an der Ausrichtung auf Bildungsziele und fundiertem Wissen.

In diesem Vortrag werde ich die wichtigsten Herausforderungen bei der Entwicklung verallgemeinerbarer und erklärbarer Modelle sowie unsere Lösungen zur Bewältigung dieser Herausforderungen diskutieren, darunter Modelle zur Verfolgung des Lernens in offenen Umgebungen und zur Verallgemeinerung zwischen verschiedenen Umgebungen und Gruppen. Ich werde unsere Arbeit im Bereich der erklärbaren KI vorstellen, darunter eine strenge Bewertung bestehender Ansätze, die Entwicklung von inhärent interpretierbaren Modellen sowie Studien zur effektiven Kommunikation von Modell-Erklärungen. Abschließend werde ich einige unserer jüngsten Ergebnisse präsentieren, bei denen „traditionelle” Modellierungsansätze und LLMs kombiniert werden, um interpretierbares Feedback und Erklärungen zu liefern, ohne die Vertrauenswürdigkeit des Modells zu beeinträchtigen.

Drei zentrale Take-aways aus Vortrag & Diskussion

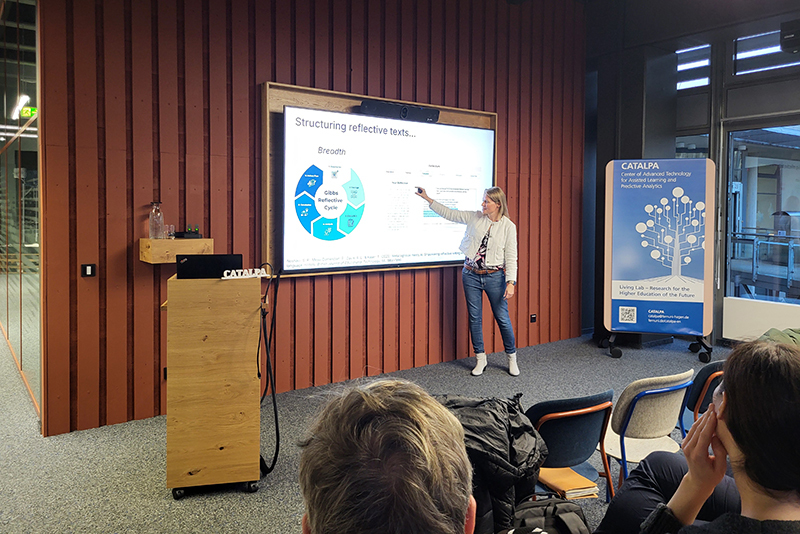

Foto: CATALPA

Foto: CATALPA- Ein möglicher Haken von Personalisierung:

So viel Potenzial Large Language Models für personalisierte Lernunterstützung bieten: Ihre Trainingsdaten bilden immer einen Durchschnitt der Gesamtheit ab. Das steht in einem Spannungsverhältnis zu echter Individualisierung – ein Punkt, der bei der Entwicklung KI-gestützter Lernsysteme unbedingt mitgedacht werden muss. - Interpretierbarkeit ≠ Explainable AI (oder doch?):

In der Praxis werden Interpretierbarkeit und Explainable AI häufig synonym verwendet. Der Vortrag machte deutlich, dass hier eine präzisere Unterscheidung notwendig ist – insbesondere, wenn es darum geht, Modelle nicht nur erklärbar zu machen, sondern sie von Grund auf inhärent interpretierbar zu gestalten. - Vertrauen entsteht durch gute Kommunikation:

Studien von Tanja Käser zeigen: Das Vertrauen von Lernenden in KI-basiertes Feedback ist noch ausbaufähig. Ein entscheidender Hebel dafür ist gute Erklärung und transparente Kommunikation. Erklärungen sind kein Add-on, sondern ein zentraler Baustein für vertrauenswürdige KI in der Bildung.

- Personenseite Tanja Käser (Englisch) | mehr

- Machine Learning for Education Laboratory (Englisch) | mehr